Vom Gehirn zu KI: Eine neue Lerntheorie über die Zeit

Eine neue Studie, die in der Zeitschrift Nature Communications veröffentlicht wurde, präsentiert eine Theorie darüber, wie das Gehirn komplexe zeitliche Muster wie Sprache, Musik oder Bewegung erlernen kann. Demnach gibt es Netzwerke von kortikalen Neuronen, die in der Lage sind, lokale Echtzeit-Signale zu analysieren und Muster zu erkennen, die sich über die Zeit entfalten. Maschinelles Lernen funktioniert nach diesem Prinzip, sodass diese Studie eine Brücke zwischen Neurowissenschaft und maschinellem Lernen schlägt. Die Ergebnisse könnten nicht nur unser Verständnis der Gehirnfunktion verbessern, sondern auch neue Generationen energieeffizienter künstlicher Intelligenzsysteme inspirieren.

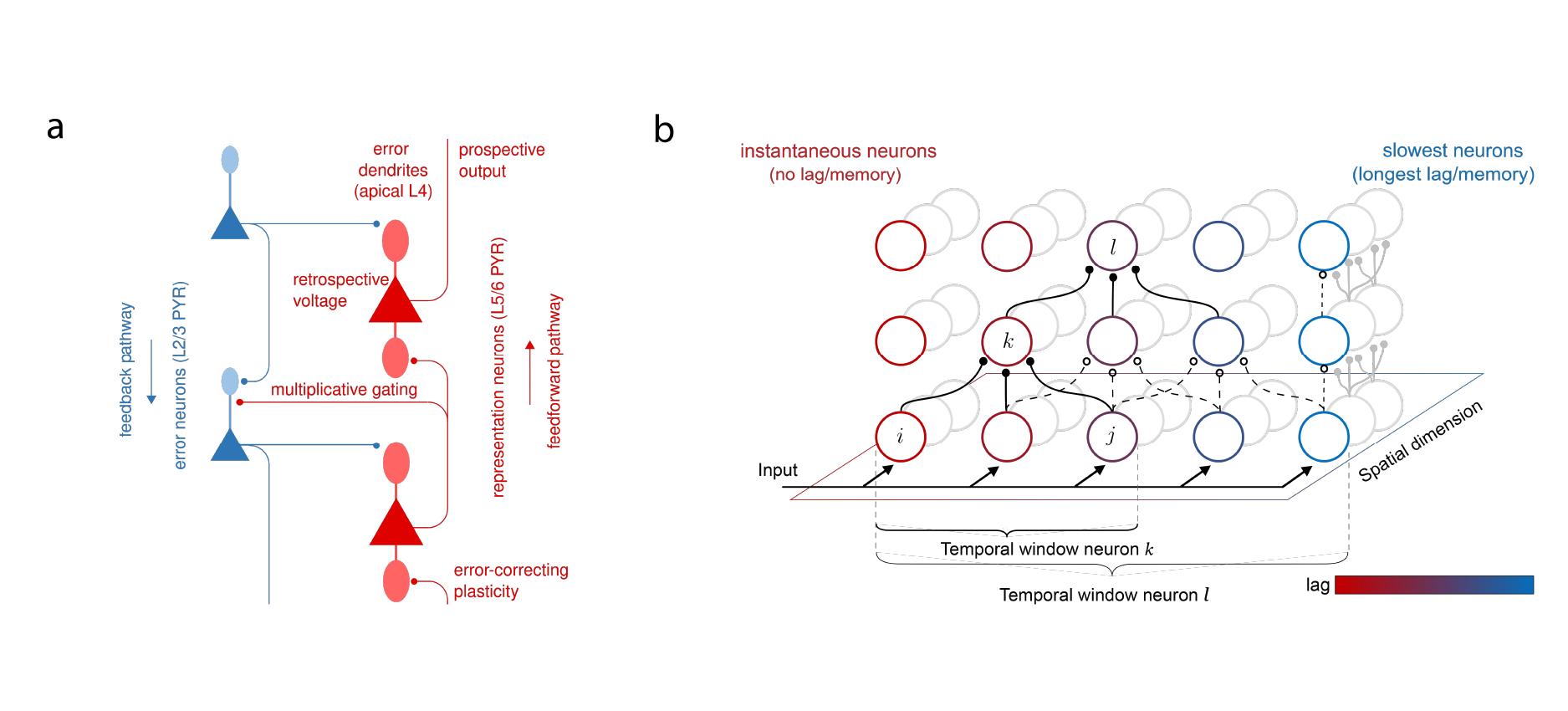

Links: Vorwärts- und Rückwärts-Informationspfade unter Nutzung von Pyramidenneuronen zur Signal- und Fehlerweiterleitung. Rechts: Neuronen in verschiedenen Bereichen des Kortex lernen, ihre Aufmerksamkeit auf unterschiedliche räumliche und zeitliche Ausschnitte zu richten, und bilden so spatiotemporale Faltungsnetzwerke. © Federico Benitez

Beteiligte Bernstein Mitglieder: Paul Haider, Federico Benitez, Mihai A. Petrovici

In heutigen künstlichen neuronalen Netzen basiert das Erlernen zeitlicher Muster – also solcher Muster, die erst dann sinnvoll sind, wenn man sie über einen längeren Zeitraum beobachtet, wie beispielsweise gesprochene Wörter oder Musik – typischerweise auf einer Methode namens „Backpropagation through Time“ (BPTT). Bei diesem Ansatz wird die Aktivität des Netzwerks während der Verarbeitung einer Sequenz aufgezeichnet und anschließend rückwärts abgespielt, während die Netzwerkparameter angepasst werden. Obwohl dieser Mechanismus bei Maschinen sehr effektiv ist, galt ein derartiger Mechanismus lange als biologisch unplausibel, denn das Gehirn kann keine detaillierten Aktivitätsspuren speichern und rückwärts abspielen. Desweiteren haben einzelne Synapsen nur Zugriff auf Informationen benachbarter Neurone.

„Wir sehen das jetzt anders“, sagt Paul Haider, einer der Erstautoren der aktuellen Studie. „Unsere Arbeit zeigt, dass tiefe kortikale Netzwerke BPTT approximieren können, ohne dass eine Rückwärstwiedergabe der Aktivität erforderlich ist.“

Die zentrale Erkenntnis liegt in einer Eigenschaft kortikaler Neurone, die bisher wenig Beachtung gefunden hat: ihrer Fähigkeit, ihren eigenen Output in naher Zukunft zu antizipieren. Durch die Kombination von Informationen über die Gegenwart mit Vorhersagen darüber, was als Nächstes wahrscheinlich passieren wird – einen Mechanismus, den die Autor:innen „prospektive Kodierung“ nennen – können neuronale Mikroschaltkreise aus sich entfaltenden Sequenzen lernen. Diese Theorie leitet sich aus einer von der Physik inspirierten, energiebasierten Formulierung ab, bei der Lernen der Reduzierung einer internen „Energie“ entspricht, die widerspiegelt, wie falsch die Ausgabe des Netzwerks ist. Aus diesem Prinzip leiten die Forschenden lokale neuronale Dynamiken und synaptische Lernregeln ab, die der Backpropagation durch Raum und Zeit sehr nahekommen.

Entscheidend ist, dass diese Ergebnisse nicht nur zu einem besseren Verständnis des Lernens im Gehirn beitragen, sondern auch eine Blaupause zur Verbesserung künstlicher Systeme liefern, indem sie sich von ihrem biologischen Vorbild inspirieren lassen. Herkömmliche Computerarchitekturen leiden unter dem berüchtigten von‑Neumann‑Engpass. Dieser bezeichnet den verschwenderischen Transport von Daten, der durch die Trennung von Rechen‑ und Speichereinheiten erforderlich ist. Das vorgeschlagene Modell umgeht diesen Engpass, indem es alle erforderlichen Lernsignale genau dann und dort bereitstellt, wo sie gebraucht werden. Dadurch wird effizientes In‑Memory-Computing ermöglicht. Dies kann dazu beitragen, die enorme Energiedifferenz zwischen künstlicher und biologischer Intelligenz zu verringern.

Lern‑Symmetrie

Diese Studie baut auch auf früheren Arbeiten der Arbeitsgruppe auf, die 2024 in Nature Machine Intelligence veröffentlicht wurden (s. Weiterführende Verlinkungen) und sich mit einem seit langem bestehenden Einwand gegen das gehirnähnliche Lernen befassten. In künstlichen Netzwerken erfordert das Lernen rückwärts gerichtete Signale, um Vorwärtsverbindungen präzise widerzuspielgeln. Diese Anforderung ist als Gewichtstransportproblem bekannt und galt lange als unvereinbar mit der Biologie. Die frühere Studie zeigte, dass kortikale Synapsen dieses Spiegeln lokal lernen können, indem sie das im Gehirn allgegenwärtige neuronale Rauschen ausnutzen.

Implikationen für biologische und künstliche Gehirne

„Wir glauben, dass diese Ergebnisse aus zwei Gründen für die breite Öffentlichkeit von Interesse sind“, sagt Mihai A. Petrovici, der Leiter des Berner Teams. „Erstens haben wir nun eine starke Hypothese, um besser zu verstehen, wie unser Gehirn lernt. Zweitens haben wir nun Blaupausen für leistungsfähigere, aber auch energieeffizientere KI.“

Das Projekt verbindet Erkenntnisse aus den Bereichen Neurowissenschaft, Physik, Mathematik und Informatik. Ein solcher interdisziplinärer Ansatz wird weltweit von nur wenigen Forschungsteams verfolgt. „Unser Team ist als Projektpartner und wichtiger Beitragender des Human Brain Project und EBRAINS gewachsen und hat stark von der hohen Interdisziplinarität dieser Initiativen profitiert“, erklärt Petrovici. „Das ist ein einzigartiger Vorteil unter den großen neurowissenschaftlichen Forschungsprojekten.“

Die Forschenden betonen, dass diese Arbeit erst der Anfang ist. „Da diese Ergebnisse sowohl für biologische als auch für künstliche Gehirne von Bedeutung sind, wollen wir sie in beide Richtungen weiterverfolgen“, sagt Federico Benitez, Co‑Autor der Studie. Auf neurowissenschaftlicher Seite sucht das Team nun nach Anzeichen seiner Modelle in Gehirndaten. Dazu arbeitet es unter anderem mit dem Team zusammen, das The Virtual Brain entwickelt hat – eine Simulationsplattform, die über EBRAINS verfügbar ist.

„Der größte Wirkung außerhalb der Grundlagenforschung könnte jedoch daraus entstehen, diese Modelle tatsächlich in Silizium umzusetzen“, ergänzt Petrovici. Gemeinsam mit Partnern von der Yale University arbeitet das Team an der Entwicklung neuartiger Schaltkreise, die das Modell direkt in Hardware implementieren könnten. Dadurch wäre Echtzeitlernen mit deutlich niedrigeren Energieanforderungen als bei heutigen KI‑Systemen möglich.

Übersetzt aus dem Englischen von Elena Reiriz Martínez & Alexandra Stein/BCOS