Hörst du, was ich sage?

In einer neuen Studie zeigt ein Team von Neurowissenschaftlern der TU Dresden erstmals, dass bei Menschen Spracherkennung bereits in den Leitungsbahnen vom Ohr zur Großhirnrinde beginnt und nicht, wie bisher angenommen, ausschließlich in der Großhirnrinde selbst.

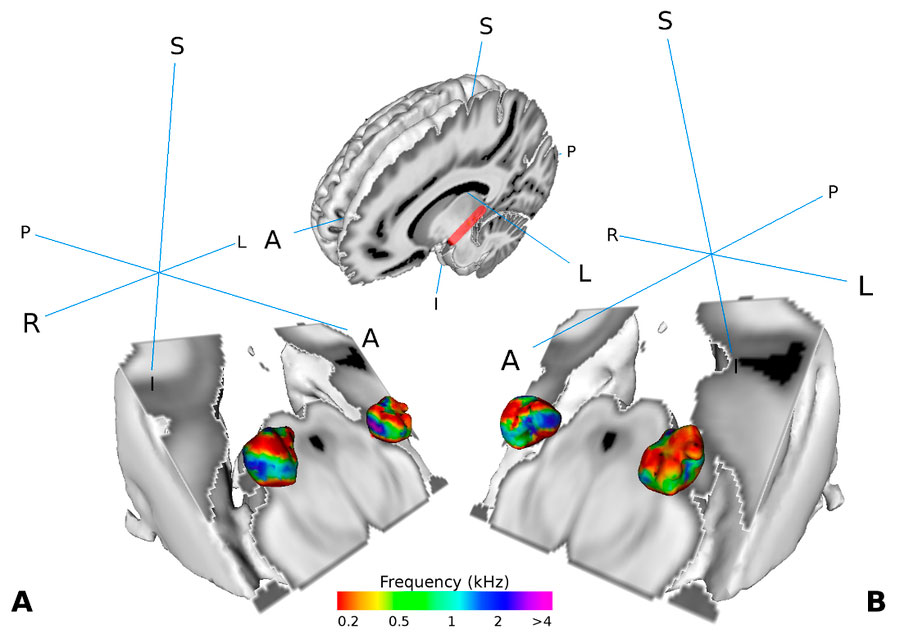

Darstellung des medialen Kniehöckers im Gehirn von menschlichen Testpersonen. Der mediale Kniehöcker ist Teil der Hörbahn. Er ist so organisiert, dass bestimmte Abschnitte bestimmte Tonfrequenzen repräsentieren. In ihrer Studie konnte das Dresdner Wissenschaftlerteam zeigen, dass der Teil des medialen Kniehöckers, der Information vom Ohr an die Großhirnrinde weiterleitet an menschlicher Spracherkennung aktiv beteiligt ist. © Mihai et al. 2019, CC-BY license

/TU Dresden/ In vielen Haushalten sind Sprachassistenten heute nicht mehr wegzudenken – sie schalten Geräte ein oder aus, berichten über die Nachrichten aus der ganzen Welt oder wissen, wie das Wetter morgen wird. Die Spracherkennung dieser Systeme basiert zumeist auf maschinellem Lernen, einem Teilgebiet der künstlichen Intelligenz. Die Maschine generiert ihr Wissen aus immer wiederkehrenden Mustern von Daten. Durch den Einsatz von künstlichen neuronalen Netzwerken konnte die computerbasierte Spracherkennung in den vergangenen Jahren um ein Vielfaches verbessert werden.

Für Neurowissenschaftlerin Professorin Katharina von Kriegstein bleibt das menschliche Gehirn jedoch nach wie vor die „bewunderungswürdigste Sprachverarbeitungs-Maschine“. „Es funktioniert viel besser als computerbasierte Sprachverarbeitung und das wird wohl auch noch eine ganze Zeit lang so bleiben“, kommentiert Frau von Kriegstein, „denn die genauen Abläufe der Sprachverarbeitung im Gehirn sind bisher noch weitestgehend unbekannt“.

Die Dresdner Neurowissenschaftlerin und ihr Team entdeckten in einer aktuellen Studie nun einen weiteren Baustein in dem Rätsel der menschlichen Sprachverarbeitung. In der Studie wurden 33 Versuchspersonen mit Hilfe von funktioneller Magnet-Resonanz-Tomographie (MRT) untersucht. Die Testpersonen bekamen Sprachsignale von verschiedenen Sprecherinnen und Sprechern zu hören. Dabei sollten sie in wechselnder Reihenfolge eine Sprachaufgabe oder eine Kontrollaufgabe zur Stimmerkennung durchführen. Das Wissenschaftlerteam nahm die Gehirnaktivität der Testpersonen während des Versuchs mit Hilfe der MRT auf. Die Auswertung der Aufnahmen zeigte, dass eine Struktur in der linken Hörbahn – der mediale Kniehöcker – besonders hohe Aktivität hat, wenn die Versuchspersonen eine Sprachaufgabe durchführen (im Gegensatz zu der Kontrollaufgabe) und wenn die Versuchspersonen besonders gut im Erkennen von Sprache sind.

Bisher nahm man an, dass alle Hörinformationen gleichermaßen über die Hörbahnen vom Ohr zur Großhirnrinde geleitet werden. Die aktuellen Aufnahmen der erhöhten Aktivität des medialen Kniehöckers zeigen nun, dass die Verarbeitung der Hörinformation bereits beginnt, bevor die Leitungsbahnen die Großhirnrinde erreichen. Katharina von Kriegstein erläutert die Ergebnisse so: „Wir haben schon seit einiger Zeit erste Hinweise darauf, dass die Hörbahnen spezialisierter auf Sprache sind, als bisher angenommen. Diese Studie zeigt nun, dass dies tatsächlich der Fall ist: Der Teil des medialen Kniehöckers, der die Information vom Ohr zu der Großhirnrinde transportiert, verarbeitet Hörinformation anders, wenn Sprache erkannt werden soll, als wenn andere Bestandteile von Kommunikationssignalen erkannt werden sollen, wie zum Beispiel die Stimme des Sprechers.“

Das Erkennen von auditorischer Sprache ist von extremer Wichtigkeit für die zwischenmenschliche Kommunikation. Das Verständnis über die zugrundeliegenden neuronalen Prozesse wird nicht nur für die Weiterentwicklung computerbasierter Spracherkennung von Bedeutung sein.

Die aktuellen Ergebnisse haben möglicherweise auch Relevanz für einige der Symptome von Lese-Rechtschreibstörung (LRS). Es ist bekannt, dass der linke mediale Kniehöcker bei LRS anders funktioniert, als bei Testpersonen ohne LRS. Die Spezialisierung des linken medialen Kniehöckers auf Sprache könnte eventuell erklären, warum Personen mit LRS häufig Schwierigkeiten haben, Sprachsignale in geräuschvollen Umgebungen (zum Beispiel im Restaurant) zu verstehen. Um diese Hinweise wissenschaftlich zu belegen, will das Team um Katharina von Kriegstein weitere Studien durchführen.

Originalpublikation

“Modulation of tonotopic ventral MGB is behaviourally relevant for speech recognition” Paul Glad Mihai, Michelle Moerel, Federico de Martino, Robert Trampel, Stefan Kiebel, Katharina von Kriegstein: eLife 2019;8:e44837 doi: 10.7554/eLife.44837