Ein künstliches Baby lernt sprechen – KI-Simulationen helfen, Prozesse im frühkindlichen Gehirn zu verstehen

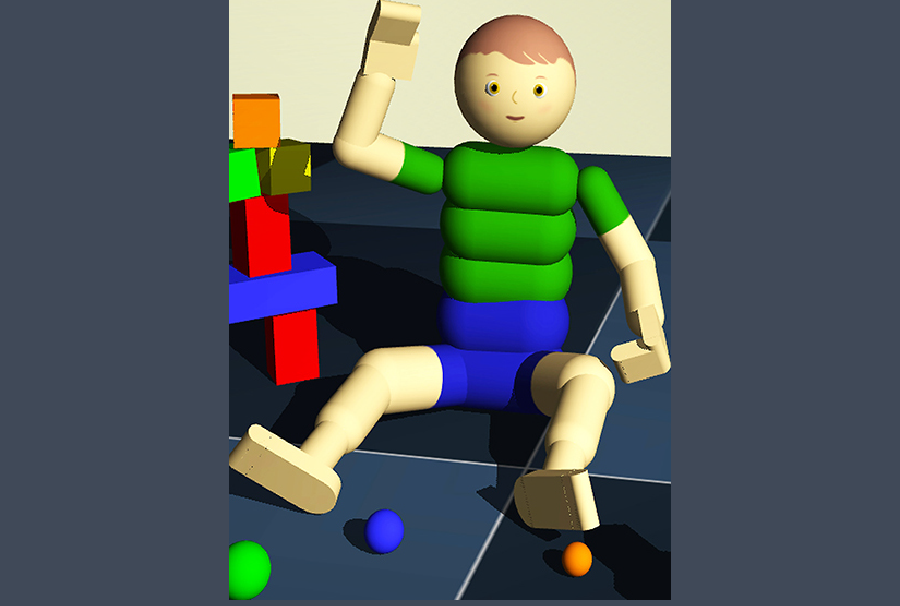

Ein simuliertes Kind und eine häusliche Umgebung wie im Computerspiel: Das sind die Forschungsgrundlagen der Gruppe um Prof. Jochen Triesch vom Frankfurt Institute for Advanced Studies (FIAS). Sie nutzt Computermodelle, um herauszufinden, wie wir sehen und verstehen lernen – und wie dies helfen könnte, maschinelles Lernen zu verbessern.

Ein Datensatz aus Bildern simuliert ein spielendes Kleinkind, das sich und Spielzeugmodelle bewegt. Das Kind »hört« gelegentlich Äußerungen der Betreuungsperson. Bild: Dominik Mattern et al., Journal of temporary stand-ins, (2024) https://ieeexplore.ieee.org/document/10382408

Beteiligte Bernstein Mitglieder: Gemma Roig, Jochen Triesch

Wie lernt ein Kleinkind, Objekte zu erkennen? Eine Banane von einem Auto zu unterscheiden, aber auch verschiedene Autos – farbig, in allen Größen, Formen und Abstraktionen – als solche einzuordnen und später auch zu benennen? Dazu muss unser Gehirn das Wissen um das Aussehen mit vielen anderen Zusammenhängen verknüpfen sowie mit dem Namen des Objekts.

Im zweiten Lebensjahr beginnen Kinder Wortbedeutungen zu verstehen und zuzuordnen. Dabei spielen Objekte und Sprache eine wichtige Rolle. Triesch und sein Team imitieren diesen Lernprozess in einer Art Computerspiel: In einem »Wohnraum« mit mehreren Gegenständen lernt ein »Kind« verschiedene Objekte kennen, die eine Bezugsperson im simulierten Zwiegespräch benennt.

Die Arbeitsgruppe Triesch hat mit dem Team von Prof. Gemma Roig vom Institut für Informatik der Goethe-Universität ein Computermodell entwickelt, das nachempfindet, wie ein Säugling lernt: das Aussehen eines einzelnen Objekts, einer ganzen Kategorie von Objekten, den zugehörigen Begriff und den Kontext. Eine Computergrafik simuliert die Seherfahrung eines Kleinkinds in einer virtuellen Wohnung. Trieschs Postdoc Arthur Aubret programmiert die Umgebung, die Handlungen und Experimente. So kann er Einflüsse systematisch variieren, etwa dass die Bezugsperson oft oder selten etwas sagt.

»Häufig richtet das Kind in dem Moment, wenn die Bezugsperson etwas sagt, nämlich gerade gar nicht die Aufmerksamkeit auf das Objekt«, so Triesch. Etwa in der Hälfte der Zeit schaut das Kind auf etwas ganz anderes, haben Forschende festgestellt. Aubret hat dies auf das Computermodell übertragen. Trotzdem funktioniert der Lernprozess. Dabei ist er viel komplexer, als man auf den ersten Blick meinen könnte: Das Kind erforscht das Objekt von verschiedenen Seiten, um seine Dreidimensionalität kennenzulernen – sich also zu merken, wie ein Auto von vorne, unten, oben und seitlich aussieht. Zudem kann ein gleichbenanntes Objekt aus unterschiedlichen Materialien bestehen – Metall, Plastik, Stoff, Holz – sowie sich in Form und Größe unterscheiden. Das Gehirn muss also eine Klassenzugehörigkeit schaffen – in diesem Fall mit dem Überbegriff »Auto«.

Wie ein Spielzeugauto räumlich aussieht, lernt ein Kind, indem es das Spielzeug von verschiedenen Seiten erforscht.

Fotos: R_yuliana/Shutterstock

Schubladendenken ist wichtig für das Gehirn

»Spannend ist, dass die Menge der Informationen in einem Bild ungeheuer hoch sein kann«, erklärt Triesch. Zum einen können andere Dinge im Sichtfeld sein, Spielzeug oder Möbel beispielsweise. Und während das Kind spielt, kommentiert die Bezugsperson zwar manch-mal – »oh, wie schön, da hast du einen Ball« –, redet aber häufig auch über andere Objekte. Das scheint den Lernprozess kaum zu stören, so die Erkenntnis der Forschenden. Die Interaktion ist wichtig, aber wenn die Aufmerksamkeit hier und da auf das falsche Objekt gerichtet wird, hat das keinen starken negativen Einfluss. »Und mehr Zuwendung, also ständig alles zu kommentieren, fördert den Lernprozess kaum«, so Triesch.

Besonders fasziniert ist der Wissenschaftler von den Konzepten, die sich in unserem Kopf formen: Die Zuordnung von Ähnlichem, räumlich oder zeitlich Zusammengehörigem ist deutlich anspruchsvoller als das, was Künstliche Intelligenz bislang zu leisten vermag. Das Hirn verknüpft ein flexibles Aussehen zudem mit einem Wort und legt somit die Grundlage für Sprache und Kommunikation. Wie wichtig das für unsere Sozialisation ist, hat Peter Bichsel schon vor über 50 Jahren in seiner Kurzgeschichte »Ein Tisch ist ein Tisch« dargestellt: Dort erfindet ein einsamer Mann seine eigenen Benennungen und wird damit zum Außenseiter.

Das lernende Kleinkind-Gehirn verknüpft benachbarte Dinge als ähnlich und verbindet das Sehen (und Fühlen, Riechen) mit dem Hören: Das deutsche Wort »be-greifen« beschreibt diesen Vorgang recht bildlich. »Unser Computermodell ist nicht genaue Realität«, schränkt Triesch ein, »aber die Mechanismen bilden die Prozesse hinreichend ab.« Sie bauen die Interaktionen nach, die zu den entsprechenden Verknüpfungen führen. Und sie erlauben zu verstehen, wie diese Prozesse im Gehirn funktionieren.

Zudem erkennt das Gehirn höhere Strukturen, etwa dass bestimmte Geräte in die Küche oder ins Bad gehören. Eine Gabel und ein Teller haben für uns den gleichen Kontext: Sie gehören in die Küche. Wenn unser Gehirn Gegenstände aufgrund ihrer Bedeutung und Funktion zueinander in Beziehung setzt, nennt man das eine »semantische Verwandtschaft«. Aber wie lernt unser Gehirn diese Zusammenhänge?

»Den verbindenden Zusammenhang von Objekten, also etwa Küche oder Schlafzimmer, speichert das Computermodell ähnlich wie beim Menschen in höheren Schichten des Netzwerks«, schreibt das Autorenteam. Die Identität oder Kategorie eines Objekts spiegeln hingegen Schichten auf niedriger Ebene besser wider. Dieses mehrschichtige Modell ahmt die hierarchische Informationsverarbeitung der Sehrinde (visueller Cortex) nach: Frühe Schichten entsprechen dabei frühen Verarbeitungsstufen im Gehirn und späte den höherstrukturierten. Sowohl das Computermodell als auch das menschliche Gehirn nutzen dafür zwei sich ergänzende Lernstrategien: Die Verknüpfung von Bild und Sprache stellt sicher, dass verschiedene Objekte derselben Kategorie ähnlich dargestellt werden.

Moderne KI aus dem menschlichen Lernprozess entwickeln

»Mit diesem Wissen könnte man Computer bauen, die autonomer lernen – eben wie ein Kleinkind«, hofft Triesch. Bislang basiert KI auf Unmengen von Daten, die im Internet hinterlegt und mittlerweile fast erschöpfend ausgewertet sind. Dieses passive Lernen aus Daten unterscheidet sich vom aktiven Lernen eines Kleinkinds, das aus wenigen Informationen, eigener Beobachtung und Kommentaren von Bezugspersonen ein komplexes Verständnis der Welt entwickelt. Es speichert nicht nur das Aussehen eines Objekts, sondern auch Kategorien und Bedeutungszusammenhänge gemeinsam mit dem dazugehörigen Wort. Triesch sieht dies als eine Grundlage für die Entwicklung zukünftiger Generationen von Robotern, die ähnlich wie Kinder lernen, in ihrer Welt zurechtzukommen und mit uns darüber zu kommunizieren.

Autorin: Anja Störiko/FIAS, Quelle: Forschung Frankfurt 1.25